【创科广场】FB AAT便利视障用户 更易了解图片内容

2021-02-05 13:00

一般将图片上载至网站,都会在HTML代码使用Alt替代文字,这并非facebook,而是单纯指出图片的内容,例如描述图片的外观及功能。此举不但可在网民用户无法下载图片时,网站可以利用Alt替代文字显示图片位置,更是必做的SEO技巧,为搜寻引擎提供更好的图片描述,协助正确地将图片提供索引。因此,以往当视障用户透过屏幕阅读器浏览facebook内容时,遇到图像就会透过听到合成话音描述以播报形式读出「照片」一词,然后分享图片的发布者名字。

画面描述变得更具体

由于互联网速度愈走愈快,Alt文字对于普罗大众而言已不再是必须。再者若文字的描述单靠上传图像的人手添加,则未必完全可靠。

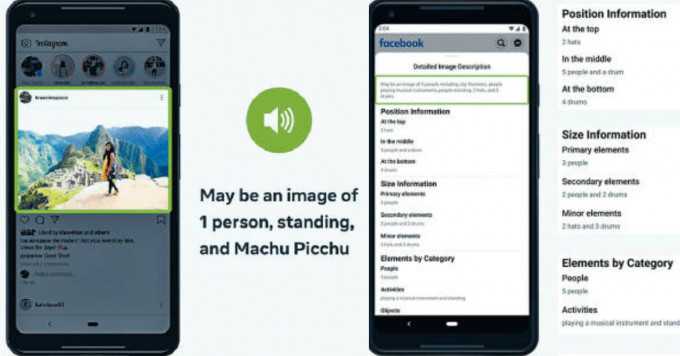

由于许多上载到社交媒体平台的图片都没有附加Alt文字,facebook在2016年引入一项自动替代文字(Automatic Alternative Text,AAT)新技术,其后在2018年更获美国盲人基金会颁发Helen Keller Achievement Award成就奖。这项技术经过多番测试,最近更作出重大改变,令照片识别的可认度大大提升,既能识别活动、地标、动物类型等,甚至在照片中加入潜在位置,辨识更多相片当中的内容,将画面描述变得更具体,令视障用户有机会读取图片内容。

根据facebook在其tech@facebook网志,AAT第一个版本是使用人类标的数据开发,透过数据将数百万个案例训练最新版本的AAT模型。完整的AAT模型可识别例如「树」、「山」等100个常见概念,亦会靠人面辨识技术识别相片中的内容是「人」。其后因为利用标记数据花费太多时间精力,因此后来演变成利用一个以数十亿张公开的Instagram图片及其标签的形式进行数据训练的模型,并进行微调,可从所有地理位置的图像撷取数据,利用多种语言的主题标签翻译,并透过文化及人口统计学的蛛丝马迹了解图片内容。例如不必仅仅单靠注解为白色婚纱的照片,也可利用传统服装识别世界各地的婚礼。

亦能了解社交网站销售内容

其后由facebook AI Research开发使用Detectron2训练一个称为Faster R-CNN的检测器作为开源平台,预测图像中的对象位置和语义标签,透过采集多标签及多数据,令其模型变得更为可靠,可识别1200多个概念,比最初发布的原始版本多达十倍。不过为求精准,facebook也会在每个描述以「可能会」(Maybe)作为开头以免有误差或歧义。现时所有替代文本说明,可用45种不同语言列出。

新版本的AAT自动替代文本技术使相片描述更精准及更容易明白,更进一步帮助视障用户理解家人和朋友在社交媒体平台发布的照片内容,同时亦能了解社交媒体网站销售内容。此举对于普遍用户来说,或未必轻易察觉,但这项技术弥合了过往的差距。对于视障用户来说,可能对于社交媒体有更深层的另一番体会。

關鍵字

最新回应