【创科广场】交谈式AI进入新时代 Google年度开发者大会卷土重来

2021-05-28 11:00

Google影响力已无孔不入,从广告、搜寻、地图、Google相簿、购物。虽然说,相比于设计精巧的苹果iOS作业系统,Google的Android显得简陋,苹果的流动应用,却仍不是Google对手,无论是利用那一个流动平台,不少人仍靠Google地图,了解路面情况。

Google地图也拥有最多数据,可以优化预测模型,一直遥遥领先,Google发现最短的路綫,未必是最佳的路綫,利用机器学习及所收集路面资讯,可让驾驶者预早做好减速准备,甚至选用其他较不挤塞路綫。

Map终于关心行人

Google利用了两组数据训练机器学习;包括Google地图手机侦测到路面可能发生挤塞,而必须突然减速情况,包括利用了Google地图导航的车辆;如备有Android Auto汽车采集的路綫资讯,预测某段路可能发生突然塞车,减少需要突然煞车,以至辨识畅快的行车路綫,同时建议多一条最相近路綫,帮助行车顺畅安全。

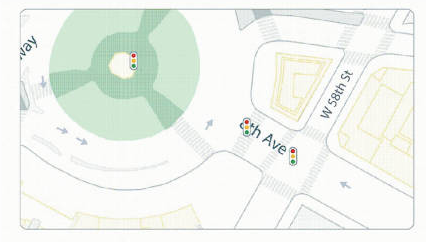

以往司机使用Google地图寻路,愈来愈多行人,也靠地图找目的地,Google提升了实景(Live View)功能,加强地图的细节,即时从Google地图浏览路面的实景,检视周边的商店及餐厅相关资讯,从实景直接找到方向和位置。

Google地图全新的街道符号,可更清楚标示复杂十字路口,甚至红绿灯和过马路辅助綫,显示出用家所在位置与目的地之间距离。去年推出的详尽街道地图,今年底会覆盖多达50个城市,包括香港在内。

根据Google对全球城市面貌的认识,Google地图能显示大大小小的行人路、斑马綫、安全岛等设施准确位置,按比例呈现道路形状,甚至是阔度,以方便行人,尤其轮椅或婴儿车的用户,策划合适路綫,显示区域的繁忙程度,区内热点如某街道,是否比平日繁忙。

根据当前时段,亦可显示地点的最相关资讯。例如一般平日上午,打开Google地图,只显示已开的咖啡店,不显示晚饭热点,以免摸了门钉。

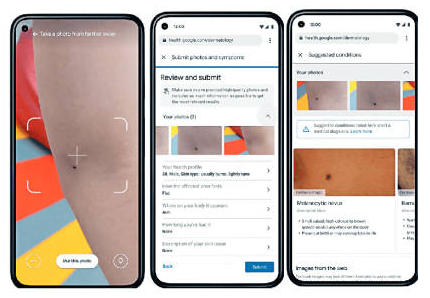

此外,利用上传照片至网络,也可自行诊检不同病徵,Google Health已训练出了侦测糖尿病视网膜病变的深度神经网络,去年在泰国测试医疗 AI模型,以自行检测糖尿病视网膜病变,今次则可利用手机镜头,协助分辨更多皮肤疾病。AI皮肤科辅助工具是Google网页应用,期望今年稍后推出测试版。该AI模型根据 288 种已知皮肤状况进行分析,只要拍下皮肤情况,Google可提供一系列相关症状,同时就各相关症状,显示经皮肤科医生检视过资讯、常见问题的答案和类似情况的网络照片。

Google Health设皮肤科

模型加入了年龄、性别、种族及皮肤类型等因素,Google利用约65,000张去识别化的图像及经诊断的皮肤状况病例数据、数百万张有皮肤问题的图像,以及数以千计的健康皮肤例子以便开发和调整此模型。

自然语言突破

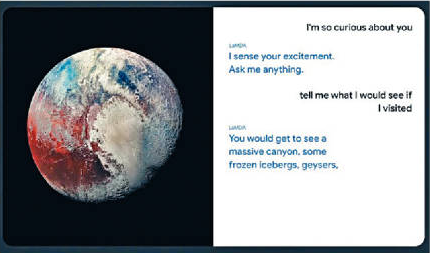

Google I/O也公布了LaMDA自然语言(NLP)模型、采用Google变革自然处理技术的神经网络架构Transformer来训练,专门针对建立聊天机械人的交谈式查询而建。LaMDA可无所不谈,不断就话题作出流顺对答。从LaMDA模型的流顺度,可见交谈式AI已进入了新时代。

大会上,Google以LaMDA化身为冥王星和纸飞机,与真人直接对话,LaMDA预计会成为支援Google Assistant的技术,交谈式机器人如Google Assistant和Siri 之类,往往答非所问;以往靠预训练的循环神经网络(RNN)模型,从用户输入估计用意,应付的不同查询要求,再从关键用语作出应对,但理解的准确度一直是大问题,不能应付复杂的交流。

以往处理自然语言训练,主要以RNN架构,2017年Google研究人员Ashish Vaswani提出Transformer模型,以一个模型处理多种NLP训练.。2018年底,基于Transformer架构已出现一大批预训练的语言模型,包括BERT、Transformer-XL,GPT-2,重新整理不同NLP任务。当模型变得愈来愈大,样本数愈来愈多的时候,Transformer显得更有好处。

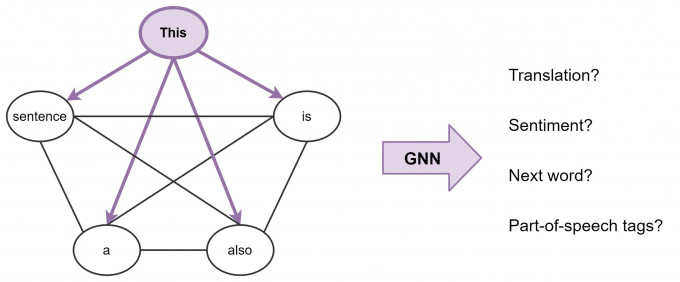

Transformer实际上是建基于Graph Neural Networks(GNN)。近年社交媒体兴起,由18世纪瑞士数学家Leonhard Euler发明的Graph theory,也大放异彩,已经在社交媒体分析,甚至在Microsoft的Microsoft 365上应用。

GNN妙用无尽

Google的DeepMind在Graph theory有深刻研究,去年DeepMind的Petar Velickovic就在人工智能深度学习2020年度ICLR顶级学术会议上,介绍以Graph Theory作AI推理,Google利用他的AI理论应用,预测交通获得成功。

所有AI神经网络架构处理自然语言,都是建立输入数据的代表(Representations),变成向量(Vector)或嵌入矩阵(Embedding Matrix)以训练模型,将有用的统计或语义数据进行编码计算成不同的模型。因为语言属于序列的数据,传统RNN对每个词建立代表,学习人类语言对话,词汇多是以前馈(Feedforward)或多次自回归再前馈方式,从左到右(或从右至左,视乎语文)来回处理再变成输出,结束时可得到每个词,在整个句子中的隐藏特徵,就知道句子所含意思,究竟「Bank」是「银行」还是「堤岸」,但如果两个关连字,彼此相距太远,RNN就要多重来回运算才知道,很不化算。

但是GNN则利用节点(Nodes)和边缘(Edges)关系,通过代表建立的「图形」(Graph)节点和边缘,以「邻域聚合(Principal Neighborhood Aggregation)实现计算句字,每个节点从其相邻处收集语言的隐藏特徵,再通过递回聚合和转换邻域节点的代表的向量数值,也就是Attention,毋须关心彼此距离,消耗的算力远比RNN少。

https︰//ai.googleblog.com/2017/08/transformer-novel-neural-network.html GNN在深度学习,特别是序列和非结构性数据,比传统的RNN更高效。近年,香港中文大学、北京清华、腾讯AI Lab都有大量关于GNN研究,GNN论文也在多个顶级会议上急增,显示未来成为研究热点。

Google也推出新一代TPU v4 晶片、Google Workspace协作新模式和Google Health的新功能。而Android作业系统也出现大型设计改善,推出了12的Beta版本,由颜色、标记形状、光暗到动态都焕然一新,功耗亦更低。

關鍵字

最新回应