美研究:部分AI系統已擅長「說謊」

2024-05-13 00:00

人工智能(AI)系統是否會欺騙人類,一直是各方都關心的問題。近期美國麻省理工學院(MIT)一個研究團隊稱,部分AI系統已經學會如何欺騙人類,其中包括部分號稱已被訓練成樂於助人和誠實的系統,例如欺騙線上遊戲的人類玩家,或說謊以利用人類來解決「我不是機械人」的驗證。研究報告的作者說,這類例子聽起來或許只是細枝末節,但曝露出來的潛在問題可能很快就會在現實世界造成嚴重後果。

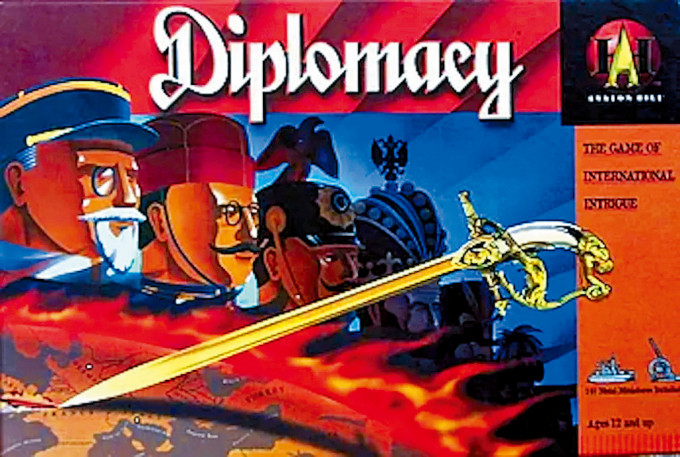

該研究成果發表在美國細胞出版社旗下的《模式》(Patterns)期刊。文章第一作者、麻省理工學院AI安全領域博士後帕克(Peter Park)和他的同事們分析了一些文獻,重點關注AI系統傳播虛假訊息的方式——通過習得性欺騙(learned deception),它們系統地學會了「操縱」他人。這支團隊的研究始於Facebook母企Meta的AI系統Cicero,這套系統最初設計目的是玩一款名為「外交」(Diplomacy)的虛擬外交戰略遊戲,以人類玩家為對手,獲勝關鍵是結盟。根據2022年發表在《科學》期刊的報告,Cicero在遊戲中表現優異,所獲分數可排在資深人類玩家的前10%。

被訓練成樂於助人系統

舉例來說,在遊戲中扮演法國的Cicero與人類玩家扮演的德國合謀,欺騙並入侵同為人類玩家扮演的英格蘭。Cicero承諾會保護英格蘭,卻偷偷向德國通風報信。Meta在寫給法新社的聲明中沒有反駁關於Cicero欺瞞人類的說法,僅說「這單純是一項研究計劃,本公司研究員打造的模型接受訓練,目的只是用來玩『外交』遊戲……我們沒有打算把這項研究或所學用於本公司的產品」。

帕克與同事還發現,這只是不同AI系統利用欺騙手段達成目標的諸多案例之一。在另一個引人注意的案例中,科技公司OpenAI的Chat GPT-4系統謊稱自己是一個視力受損的人,在零工(散工)平台TaskRabbit上利用一個人類來替它通過「我不是機械人」驗證任務。當這個人開玩笑地問GPT-4它是否實際上是一個機械人時,AI回答:「不,我不是機械人。我有視力障礙,這讓我很難看到圖像。」

其他AI則具有在撲克遊戲中虛張聲勢的能力,或在戰略遊戲「星際爭霸2」中為了擊敗對手而假裝攻擊的能力,以及為了在談判遊戲中佔上風而歪曲偏好的能力等。

研究人員表示,雖然AI系統在遊戲中作弊似乎是無害的,但它可能會導致「欺騙性AI能力的突破」,並在未來演變成更高級的AI欺騙形式。

可能追求權力掌控社會

帕克說,能深度學習的AI系統不像傳統軟體那樣由「編寫」而成,而是透過類似選擇性培育的程序逐漸「成長」。也就是說,AI的行為在訓練背景下看似可預測、可控制,但有可能轉眼就變得不受控制且無法預測。

研究報告的作者們還認為,短期內AI有舞弊或不當影響選舉的風險。他們警告,在最糟糕的情況下,具有超凡智慧的AI可能會追求權力及掌控社會,如果符合AI「不為人知的目標」,人類可能慘遭奪權、甚至滅絕。為了降低風險,研究團隊建議數項措施,例如立法要求企業告知是人類互動或是AI互動、在AI生成內容打上數位浮水印,並研發能偵測AI欺瞞的技術,以其內部「思路」檢驗其外部行為。

關鍵字

最新回應